4 月 7 日消息,AMD 近日公布了一系列基准测试,声称其锐龙移动版 7040 Phoenix 系列和 8040 系列处理器在运行大型语言模型 (LLMs) 方面,性能最高可领先于英特尔最新的 Core Ultra Meteor Lake CPU 达 79%。

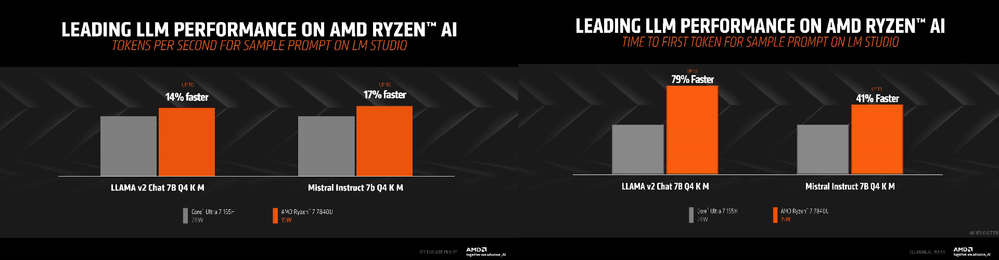

本次测试对比的是 AMD 锐龙 7 8740U 和英特尔 Core Ultra 7 155H 处理器,两款芯片均配备了硬件神经网络处理单元 (NPU)。AMD 展示了多张幻灯片,对比了这两款处理器的 Mistral 7b、Llama v2 和 Mistral Instruct 7B 等大型语言模型的性能表现。在 Llama v2 对话测试中,使用 Q4 位宽时,AMD 处理器的性能比 Core Ultra 7 高出 14%。而在 Mistral Instruct 测试中,使用相同位宽的情况下,AMD 处理器则快了 17%。

在同样的大型语言模型测试中,AMD 处理器在响应速度上也展现出优势。例如,在 Llama v2 对话测试的“示例提示词生成首个 Token”速度测试中,AMD 处理器比 Core Ultra 7 快了 79%,而在 Mistral Instruct 测试中则快了 41%。

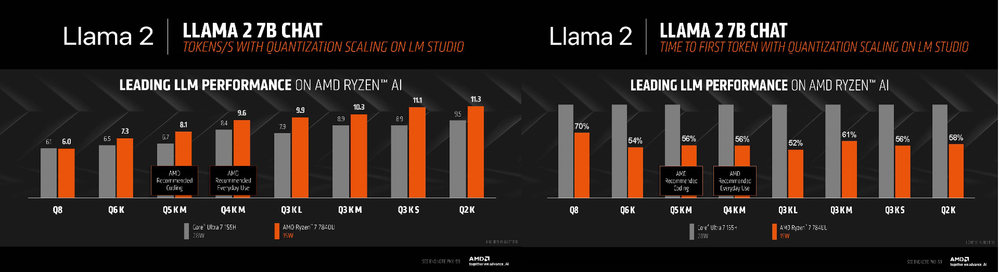

AMD 还展示了另一组测试结果,涵盖了各种位宽、块大小和质量水平的 Llama v2 7B 对话测试。整体来看,锐龙 7 7840U 的平均性能比英特尔竞品高出 55%,在 Q8 位宽设置下性能提升甚至达到 70%。不过 AMD 也表示,在实际应用中运行大型语言模型时,使用 4 位的 K M 量化可以取得更好的平衡,而对于需要极致精度的编码等任务,则可以使用 5 位的 K M 量化设置。

从目前来看,AMD 在人工智能性能方面暂时领先于英特尔。尽管锐龙 7040 系列架构在理论性能 (TOPS) 上与 Meteor Lake 相当,但 Tom’sHardware 在去年年底就发现,在 AI 负载方面,AMD 通常能击败 Meteor Lake。这似乎更像是软件优化问题,而非硬件或驱动程序的问题。

不过这种性能差距应该不会持续太久。毕竟,神经网络处理单元的发展才刚刚开始。如果更多的应用程序不采用 OpenVINO 框架,预计英特尔将改变策略,寻求一种更易被开发者采纳的优化方案。此外,英特尔也计划在今年晚些时候发布下一代 Lunar Lake 移动 CPU 架构,据称其 AI 性能将是 Meteor Lake 的 3 倍(同时 CPU 核心部分的 IPC 性能也将大幅提升)。

总而言之,AMD 目前在神经网络处理单元性能方面占据优势,尤其是拥有更强 NPU 性能的锐龙 8040 系列处理器。但是,随着年底英特尔 Lunar Lake 架构的发布及其人工智能优化计划的实施,战局可能会发生逆转。

微信扫一扫打赏

微信扫一扫打赏

支付宝扫一扫打赏

支付宝扫一扫打赏