3 月 7 日消息,AMD 公司今天发布公告,表示用户可以本地化运行基于 GPT 的大语言模型(LLM),从而构建专属的 AI 聊天机器人。

AMD 表示用户可以在包括采用 AMD 新 XDNA NPU 的 Ryzen 7000 和 Ryzen 8000 系列 APU,以及内置 AI 加速核心的 Radeon RX 7000 系列 GPU 设备上,本地运行 LLM 和 AI 聊天机器人。

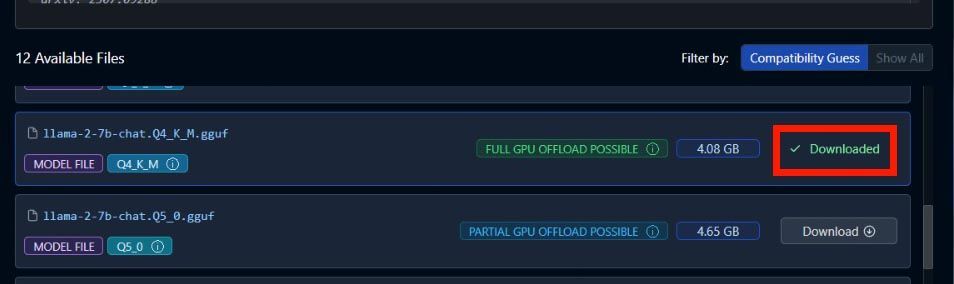

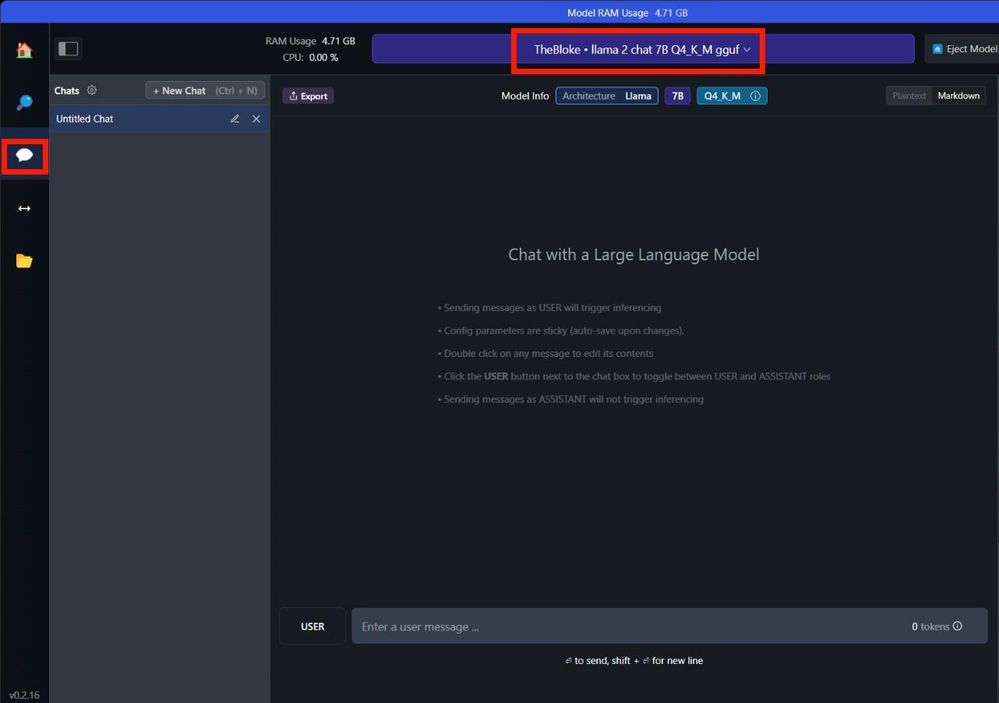

AMD 在公告中详细介绍了运行步骤,例如运行 70 亿参数的 Mistral,搜索并下载“TheBloke / OpenHermes-2.5-Mistral-7B-GGUF”;如果运行 70 亿参数的 LLAMA v2,搜索并下载“TheBloke / Llama-2-7B-Chat-GGUF”。

AMD 并不是第一个这样做的公司,英伟达(NVIDIA)最近也推出了 “Chat with RTX”,这是一个由 GeForce RTX 40 和 RTX 30 系列 GPU 支持的人工智能聊天机器人。它采用 TensorRT-LLM 功能集进行加速,基于本地化数据集提供快速生成的人工智能结果。

微信扫一扫打赏

微信扫一扫打赏

支付宝扫一扫打赏

支付宝扫一扫打赏